최근 비디오에서 신경망의 기본 구조에 대한 설명을 했습니다. 이번 글에서는 **경량화된 기계 학습의 핵심인 경사 하강법(gradient descent)**의 개념을 심도 깊게 탐구하고, 우리가 다루고 있는 신경망의 동작 원리를 자세히 알아보겠습니다. 우리의 주요 목표는 손으로 쓴 숫자를 인식하는 전통적인 사례인 MNIST 데이터셋을 통해 신경망의 학습 과정을 이해하는 것입니다.

1. 신경망의 기본 구조 이해하기

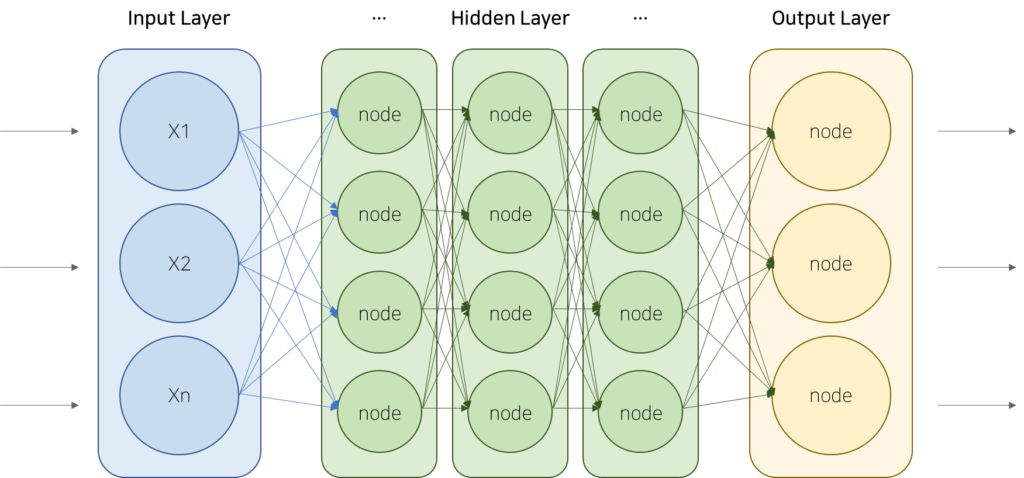

손으로 쓴 숫자는 28×28 픽셀로 이루어진 그리드에 나타납니다. 각 픽셀은 0과 1 사이의 그레이스케일 값을 가지며, 이 정보는 신경망의 입력층에 있는 784개의 뉴런의 활성화를 결정합니다. 신경망의 각 계층에서는 이전 층의 모든 뉴런 활성화 값을 가중치와 함께 더해 새로운 값을 생성하고, 이후 **시그모이드 함수(Sigmoid Function)**나 **ReLU(Rectified Linear Unit)**와 같은 비선형 함수를 적용합니다.

특정 예시로, 신경망은 약 13,000개의 가중치와 편향을 조정하며 학습을 진행합니다. 출력층에서 10개의 뉴런 중 가장 높은 값을 가진 뉴런이 분류된 숫자를 나타내게 됩니다. 이러한 기능을 통해 신경망은 주어진 입력 데이터를 해석하고 정확한 출력을 제공할 수 있게 됩니다.

2. 비용 함수와 최적화

신경망의 성능을 평가하기 위해서는 **비용 함수(cost function)**를 정의해야 합니다. 비용 함수는 모델의 출력과 실제 클래스 간의 차이를 계산하여, 네트워크가 잘못된 예측을 하고 있다면 그에 대한 ‘처벌’을 제공합니다. 예를 들어, 손으로 쓴 숫자 3을 입력했을 때 출력이 대부분의 뉴런에서 비슷한 확률 값을 발산하는 경우, 비용 함수는 큰 값을 반환하여 신경망이 부정확하다는 것을 알립니다.

비용 함수는 전체 훈련 데이터에 대한 평균 비용을 취하여 모델의 성능을 더욱 신뢰성 있게 평가합니다. 따라서 비용 함수를 최소화하는 것은 네트워크가 더 나은 성능을 발휘하는 방법이 됩니다. 이 과정에서 신경망이 어떻게 개선될 수 있는지를 파악할 수 있습니다.

3. 경사 하강법(Gradient Descent)

경사 하강법은 신경망이 비용 함수를 최소화하는 방법을 제공하는 알고리즘입니다. 이 방법은 각 뉴런의 가중치와 편향을 조정하여 비용 함수의 기울기를 계산하고, 이를 기반으로 가중치를 업데이트합니다. 기울기의 방향은 비용 함수를 감소시키는 방향으로 설정되며, 이 과정에서 각 가중치의 중요도가 반영됩니다.

경사 하강법의 원리를 설명하기 위해 자주 사용되는 비유는 “언덕 아래로 굴러가는 공”입니다. 기울기를 사용해 최소값에 접근하는 이 방법은 다차원 공간에서도 동일하게 적용되며, 이는 신경망이 13,000개의 가중치와 편향을 포함하는 복잡한 문제에서도 효과적으로 작동함을 의미합니다.

4. 신경망 성능 평가 및 개선

신경망이 적절히 학습을 마친 후, 이전에 보지 못한 새로운 이미지를 얼마나 잘 인식하는지를 평가할 수 있습니다. 초기 네트워크는 약 96%의 정확도로 이미지를 분류하였지만, 몇 가지 구조적 조정을 통해 98%의 정확도에 이를 수 있었습니다. 이는 우리가 처음 설정한 작업이 얼마나 어려운지를 고려했을 때 상당한 성과로 여겨집니다.

그러나 우리가 가진 의문 중 하나는 두 번째 계층이 실제로 무엇을 학습하는가입니다. 신경망이 매우 신뢰성이 떨어지는 방식으로 무작위 이미지를 인식할 때, 우리는 신경망이 실제로 항상 올바른 결정을 내리는 것이 아님을 알게 됩니다. 만약 신경망이 무작위 이미지를 잘 인식하지 못한다면, 이는 추가적인 조정이 필요할 수 있음을 시사합니다.

5. 신경망의 미래

현재 우리가 살펴보고 있는 신경망 구조는 과거의 기술이며, 현대의 더 복잡한 신경망 아키텍처는 훨씬 더 정교하게 발전했습니다. 이러한 신경망의 원리를 잘 이해하면, 더 나은 이미지 인식 모델을 디자인할 수 있는 기초가 마련됩니다. 예를 들어, 심층 신경망(Deep Neural Networks) 또는 합성곱 신경망(Convolutional Neural Networks)과 같은 현대 신경망 구조는 더욱 정교하게 이미지 데이터를 분석하고 분류합니다.

이해를 더욱 돕기 위해 신경망의 작동 원리에 대한 깊은 통찰력을 원하신다면, 마이클 니얼슨의 딥러닝과 신경망에 관한 책을 추천드립니다. 이 책은 무료로 제공되며, 실전 코드와 데이터를 포함하고 있어 학습에 큰 도움이 될 것입니다.

결론 및 참고 자료

이번 포스트에서는 경량화된 기계 학습 모델인 신경망의 기본 원리 및 경사 하강법을 통한 학습 과정을 심도 있게 다루었습니다. 신경망을 활용한 다양한 연구의 현재와 미래를 이해하고, 보다 발전된 기술에 대비할 수 있는 기초를 다졌습니다.

추천할 수 있는 추가 자료는 다음과 같습니다:

- Michael Nielsen의 깊이 있는 딥러닝 책.

- Chris Ola의 아름다운 블로그 포스트 및 Distill의 관련 기사.

마지막으로, 패트리온을 통해 이 콘텐츠에 지원해 주신 모든 분들께 진심으로 감사드립니다. 이러한 유익한 자료를 지속적으로 제공할 수 있도록 최선을 다하겠습니다!